) N* N h8 P7 M% V/ ]* E

作为产业链中偏工具和服务的环节,Cocos 基于沉淀多年的技术能力和与丰富的开发实践经验,致力于为元宇宙世界提供技术平台底座,降低元宇宙内容开发门槛。Cocos 即将发布自研虚拟角色编辑器,为行业提供覆盖虚拟角色创作、使用全生命周期的虚拟角色产品线。" V) m% ]; R/ V) M$ y- H9 I

近日,Cocos 虚拟角色项目团队负责人倪飞接受了 InfoQ 的专访,详细介绍了 Cocos 在虚拟角色构建上的技术创新以及应用落地实践。以下为正文。

当前,元宇宙的话题度无疑空前高涨,正迅速攀升为顶流概念。

* p5 H; a! c( ~1 i+ K& X( W# ^

在不久前 Gartner 发布的 2023 年十大战略技术趋势中,元宇宙技术上榜。Gartner 将元宇宙定义为:由虚拟技术增强的物理和数字现实融合而成的集体虚拟共享空间。

元宇宙火爆之下,虚拟人作为元宇宙的场景入口与连接纽带也备受瞩关注。艾媒咨询发布的《2022-2023 年中国虚拟人行业深度研究及投资价值分析报告》中提到,2020-2021 年,虚拟人相关企业数量逐渐呈现快速增长趋势。

9 R& T) q8 c; J, m/ v N

目前,海内外的厂商正在加快布局虚拟人赛道,尤其是巨头厂商正在占得先机。 V" w- I J4 [0 I+ l2 Y, a2 a

近两年,Cocos 将“触角”延伸到了虚拟角色领域。Cocos CEO 林顺十分看好元宇宙的发展,他认为元宇宙技术带来的颠覆性改革,或许可以媲美上一个软硬结合的划时代发明——互联网。林顺认为,元宇宙有三种呈现形态:虚拟空间、增强现实、平行世界。而不论是哪一种呈现形态,不管是哪一种虚拟世界,都需要一个强大的 3D 技术作支撑。

3D 技术正是 Cocos 的擅长领域,Cocos 在该领域已有数年技术积累,凭此入局元宇宙已是水到渠成,Cocos 更是直接成立了虚拟角色项目团队。) b' }' q) K. e" d! {+ d& A! `

在虚拟数字人产业链中,基础层为其提供必要的软件和硬件支撑;平台层为其制作及开发提供技术,连接技术和服务使之呈现出不同的虚拟人样态;应用层令虚拟数字人在各领域应用实践。9 L u/ R) Z. D; I2 x/ O4 \1 T

倪飞认为,无论虚拟角色未来会发展成什么样的应用形态,其底层是通用的工具化的能力。像 Cocos 这样长期致力于工具开发和技术能力赋能的厂商,处在虚拟数字人全产业链中偏工具和服务的环节。Cocos 更擅长做工具赋能,将工具做好赋能给第三方厂商使用。: Y+ K; C, s( t. O* n$ ]5 p" e/ a

如何在低算力终端中运行虚拟角色,是一个十分复杂的难题,需要专业积淀和积累。凭借过往在渲染层、移动端适配、工具化等方面沉淀多年的丰富技术经验,Cocos 试图让这一问题简单化。而这些经验也成为 Cocos 进入虚拟角色领域的底气和优势。 `/ z# `3 Z- o4 [

5 V/ {3 d* \# l# ^6 A* d

倪飞告诉我们:“面向未来的 3D 化交互,大致分为人、事物、组织在 3D 空间里的活动。Cocos 从发散的数字孪生的逻辑,收敛到数字孪生中的‘人’的部分,我们团队专注于通过虚拟角色构建来推动数字孪生,以及未来面向未来的 3D 交互。”. a0 }/ g S/ O4 _- K" K

如何创建一个全周期的虚拟角色?6 B: `* [" s$ a' |- D; D: \" D

基于沉淀多年的引擎底层技术能力和与开发实践经验,Cocos 为开发者提供了多个低门槛、高效率、跨平台的虚拟内容生产工具,降低整个生产链路和实际发布链路的成本和门槛,为行业提供覆盖虚拟角色创作、使用全生命周期的虚拟角色产品线。2 h9 p7 t6 M) h# c3 i8 D) P6 |" [

自研多项虚拟角色编辑工具

# f" \6 u$ y/ \

如何既能让虚拟角色动起来,又具有性格,且能够跨平台进行交互,具有相当高的技术门槛,Cocos 希望用自身擅长的工具化能力将技术门槛降下来。# ~* u0 v$ n1 i7 |2 D$ x( D' V

! f; k& ~1 o+ X4 `4 E. W

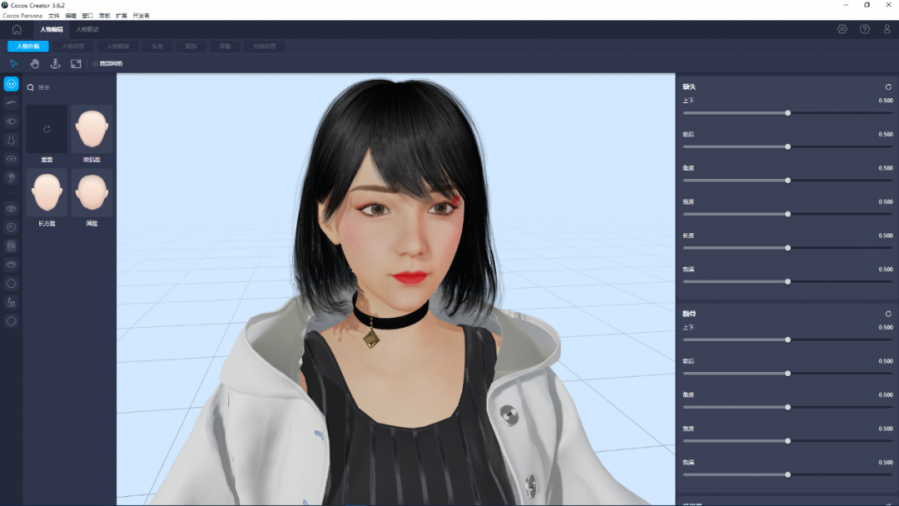

针对虚拟角色制作,目前 Cocos 已自研了 Cocos Creator、Cocos Persona Editor 编辑器、Cocos Avatar SDK 等多款虚拟角色编辑工具。

' b, k4 d' F. Q+ i% w) g4 v

Cocos 认为,虚拟角色涵盖的范畴大于数字人。目前,整个虚拟角色行业分布的大类是写实、卡通和二次元,其中,写实虚拟数字人是当下的主流方向。倪飞介绍,写实数字人、卡通数字人、二次元数字人等人形的角色都是 Cocos 的工具支持的方向,希望这些工具能够支持美术创作者自定义生产写实类或卡通类、二次元类的虚拟角色。

今年 8 月,Cocos Creator 3.6 正式发布,这一版本被官方称为是 Cocos 近两年来最重要的版本,在画面渲染、性能、原生化、编辑器优化等方面都做了大幅进化。在 3.6 版本中,引擎在 3D & 2D 开发上体验更好、性能更高、效果更出众。

倪飞介绍,Creator 3.6 版本做了更易用的封装和升级,引入了动画系统,增加了对材质和光照模型进行优化等新功能,这一新版本引擎的发布能够提高虚拟角色的表现效果,让虚拟角色呈现出的光影更加真实。0 C+ c2 r5 f6 E

目前,Cocos Persona Editor 编辑器,Cocos Avatar SDK 正在紧锣密鼓地开发中,预计不久后将正式推出。, h% L# R* r/ c5 c+ s% N

% S' H$ p! N6 k* H

采访中,倪飞向 InfoQ 透露了上述工具的一些核心功能。Cocos Avatar SDK 的核心逻辑是快速让 B 端用户拥有创建、操作虚拟角色的能力,SDK 已经适配了安卓、iOS、H5、微信小程序/小游戏端,可以直接嵌入到 APP 内,实现流量的闭环,为用户提供更好的体验,据悉目前市场上已经有知名 APP 采用了 Cocos 的这套 SDK 逻辑。

5 k% @$ m) q. {1 y4 o: p$ W* h; T

Cocos Avatar SDK 最核心的三个特点是高性能、可热更、易使用。它提供了 SaaS 化美术素材托管与热更服,通过对“指定素材的分发、热更 + SDK 展现 + 编辑器快速编辑”的逻辑,Cocos 形成了一个开箱即用的虚拟角色创建、展示能力工具集,不仅能够让传统的软件开发商无需追加 3D 开发人员即可立即拥有虚拟角色的加载、替换、捏脸、换装、插入视频播放、替换 2/3D 背景和场景、3D 空间音频等能力,而且内置动捕、面捕、WAV 口型播报等 AI 能力,能够接收本地/远程的结构化数据,驱动虚拟人进行表情、动作、口型、特效等表演。